MLOps-Strategien für skalierbare KI-Projekte [Best Practices]

KI-Projekte stehen und fallen mit der richtigen Umsetzung. MLOps spielt dabei eine Schlüsselrolle.

Wir bei Newroom Media wissen, wie wichtig effiziente MLOps-Strategien für den Erfolg und die Skalierbarkeit von KI-Initiativen sind.

In diesem Beitrag zeigen wir dir bewährte Praktiken, um deine ML-Workflows zu optimieren und nachhaltig zu gestalten.

Wie optimierst du deine ML-Workflows?

MLOps ist der Schlüssel zum Erfolg deiner KI-Projekte. Es verbindet Machine Learning, DevOps und Datenengineering zu einem ganzheitlichen Ansatz. Damit stellst du sicher, dass deine ML-Modelle nicht nur entwickelt, sondern auch effizient in Produktion gebracht und kontinuierlich verbessert werden.

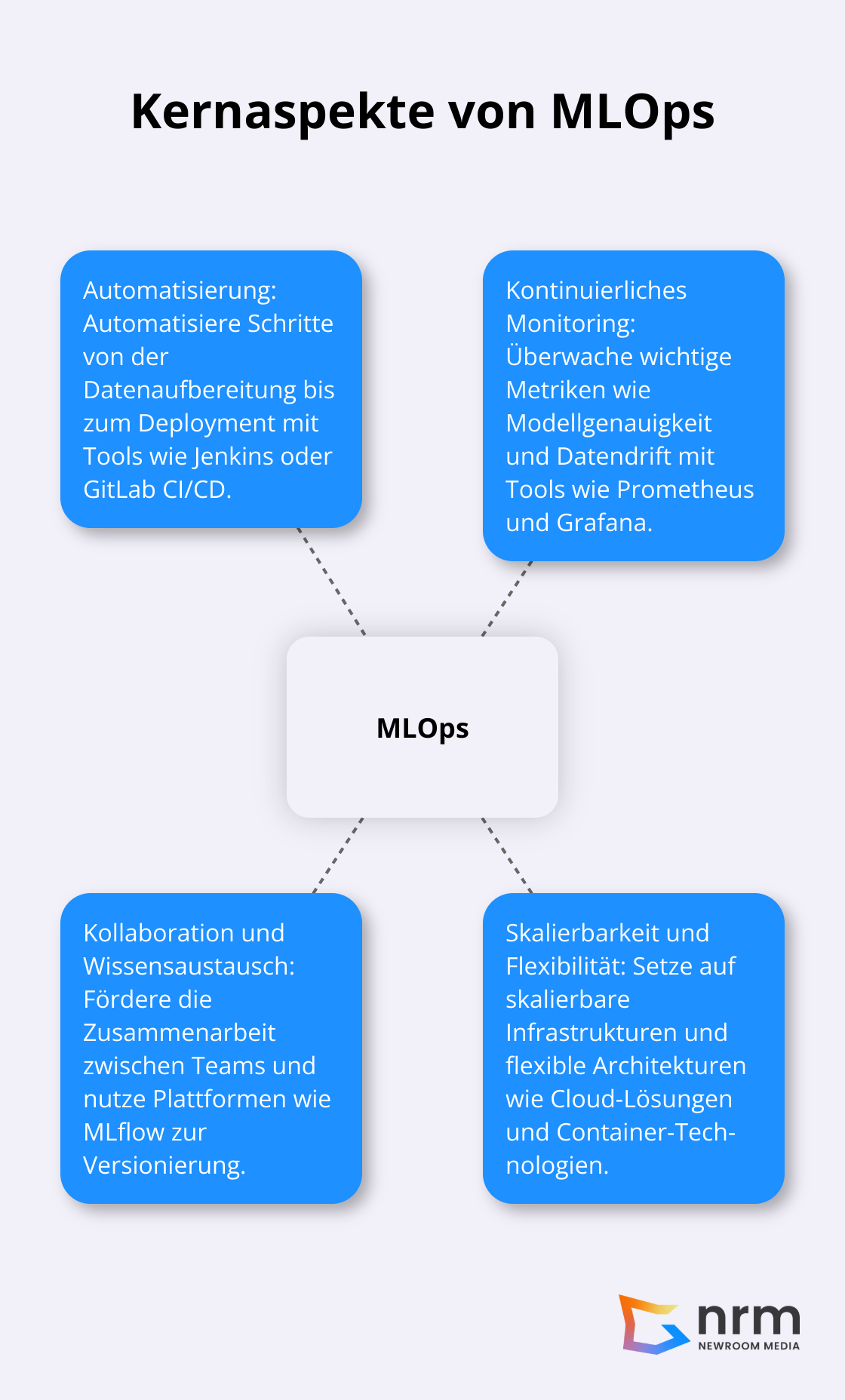

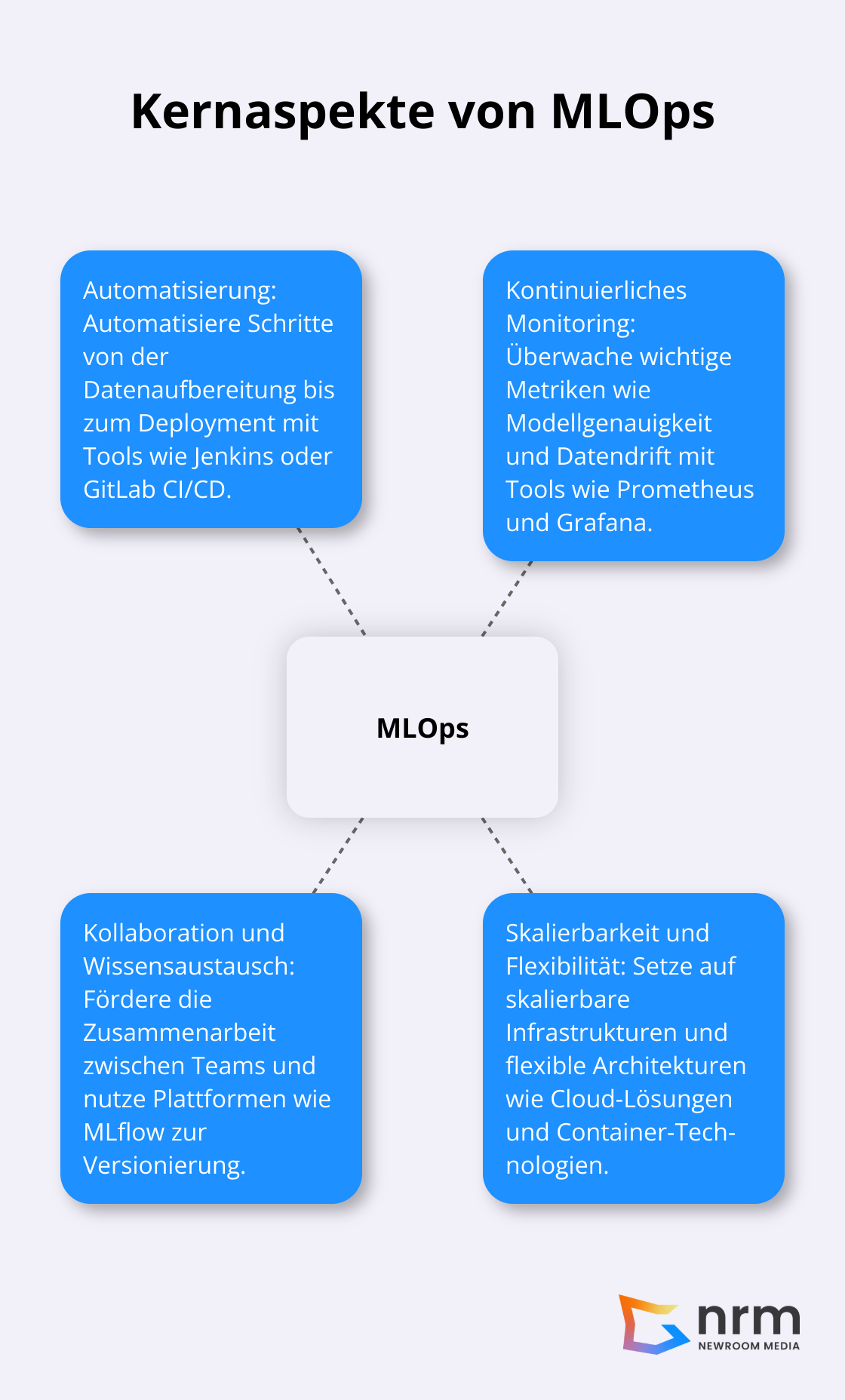

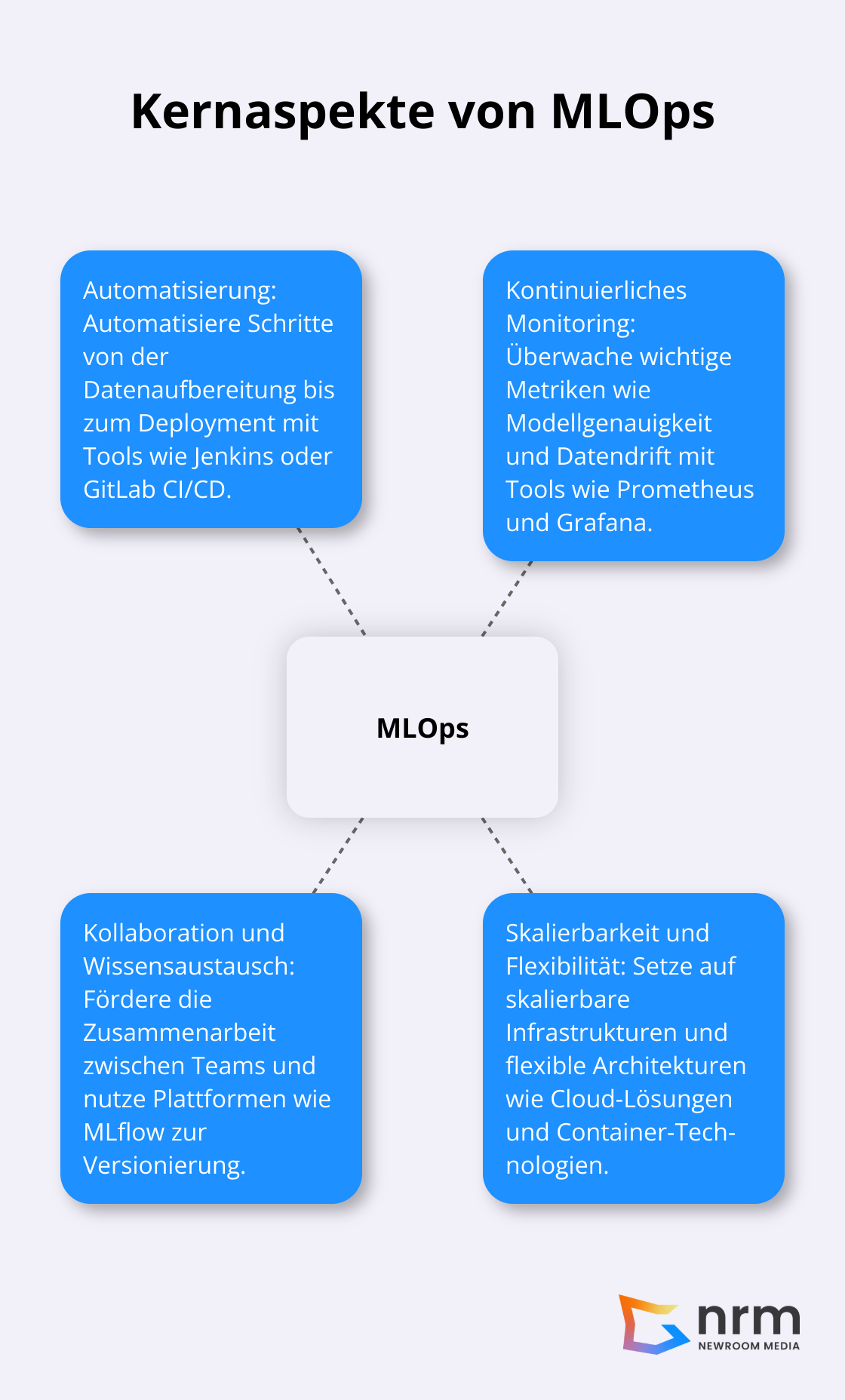

Automatisierung als Grundpfeiler

Ein zentraler Aspekt von MLOps ist die Automatisierung. Automatisiere so viele Schritte wie möglich – von der Datenaufbereitung über das Training bis hin zum Deployment und Monitoring. Tools wie Jenkins oder GitLab CI/CD (Continuous Integration/Continuous Deployment) helfen dir beim Aufbau robuster Pipelines.

Kontinuierliches Monitoring und Verbesserung

Deine Arbeit endet nicht, sobald ein Modell live ist. MLOps ermöglicht dir kontinuierliches Monitoring, um Probleme frühzeitig zu erkennen. Überwache wichtige Metriken wie Modellgenauigkeit, Datendrift oder Systemperformance.

Setze Tools wie Prometheus für das Monitoring und Grafana für die Visualisierung ein. So behältst du den Überblick und greifst proaktiv ein, bevor Probleme eskalieren.

Kollaboration und Wissensaustausch fördern

MLOps ist auch eine Frage der Unternehmenskultur. Fördere die Zusammenarbeit zwischen Data Scientists, Entwicklern und Fachabteilungen.

Implementiere Plattformen wie MLflow zur Versionierung von Modellen und Experimenten. So machst du den ML-Prozess transparent und förderst den Wissensaustausch im Team.

Skalierbarkeit und Flexibilität sicherstellen

Deine MLOps-Strategie muss mit deinen KI-Projekten wachsen können. Setze auf skalierbare Infrastrukturen (z.B. Cloud-Lösungen) und flexible Architekturen. Dies ermöglicht dir, schnell auf veränderte Anforderungen oder wachsende Datenmengen zu reagieren.

Nutze Container-Technologien wie Docker und Orchestrierungstools wie Kubernetes. Sie helfen dir, deine ML-Workflows konsistent über verschiedene Umgebungen hinweg zu verwalten und zu skalieren.

Mit diesen MLOps-Praktiken legst du das Fundament für skalierbare und nachhaltige KI-Projekte. Du steigerst nicht nur die Effizienz, sondern auch die Qualität und Zuverlässigkeit deiner ML-Lösungen. Im nächsten Abschnitt werfen wir einen Blick auf konkrete Best Practices, die dir bei der Implementierung von MLOps in deinem Unternehmen helfen.

Wie implementierst du MLOps effektiv?

MLOps ist kein Luxus, sondern eine Notwendigkeit für erfolgreiche KI-Projekte. Bei der Implementierung geht es darum, deine ML-Workflows zu optimieren und zu automatisieren. Hier erfährst du, wie du das in der Praxis umsetzt.

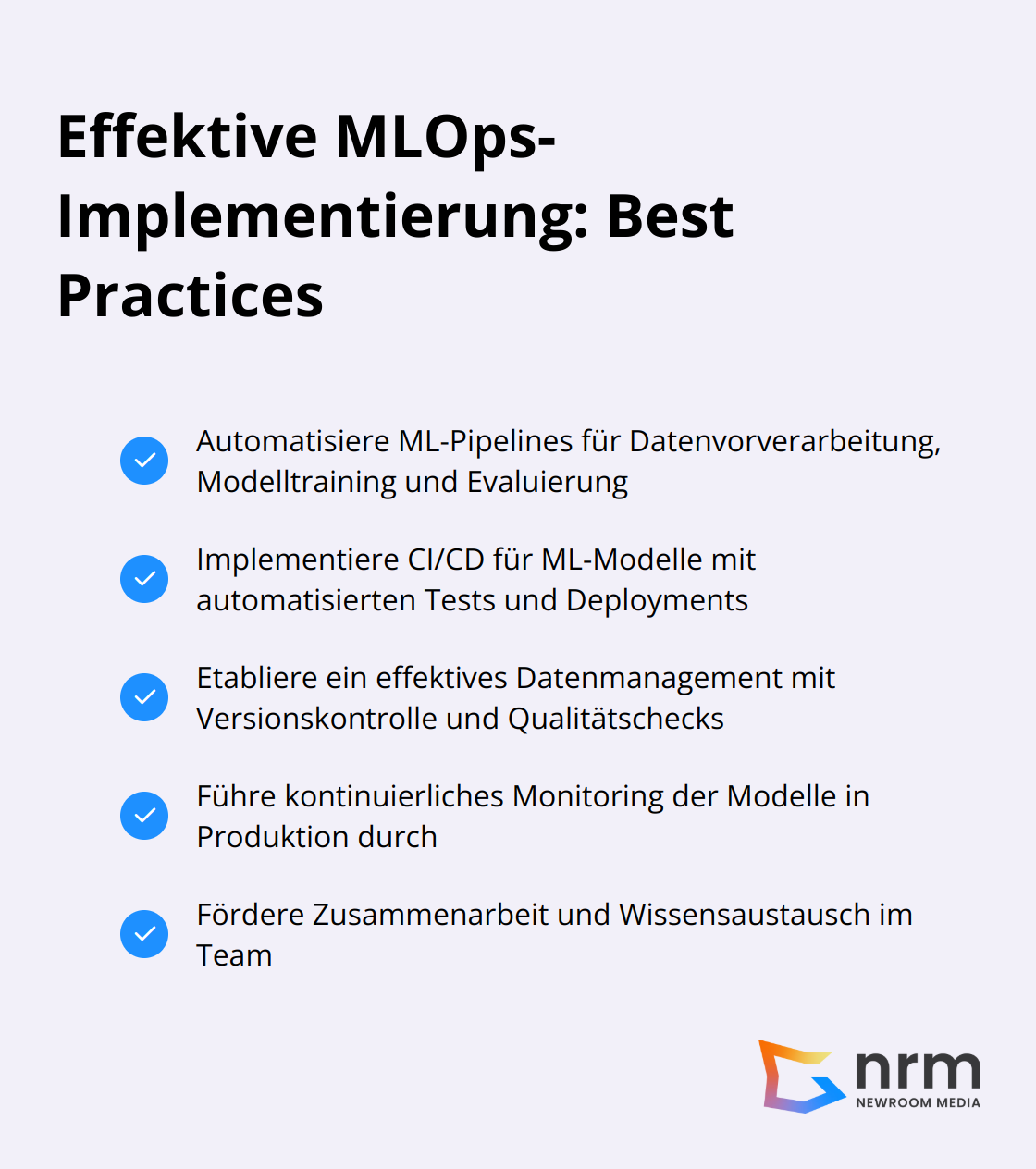

Automatisiere deine ML-Pipelines

Manuelle Prozesse sind fehleranfällig und zeitaufwendig. Automatisiere deshalb so viel wie möglich in deinen ML-Pipelines. Machine Learning-Pipelines helfen dir, Machine Learning-Workflows zu erstellen, optimieren und verwalten.

Automatisiere die Datenvorverarbeitung, das Modelltraining und die Evaluierung. So erstellst du neue Modellversionen schnell und zuverlässig. Das spart nicht nur Zeit, sondern reduziert auch menschliche Fehler erheblich.

Setze auf CI/CD für deine ML-Modelle

Wende Continuous Integration und Continuous Deployment (CI/CD) auf deine ML-Modelle an. Continuous Integration bezieht sich auf die Praktik, Codeänderungen automatisch und regelmäßig in ein gemeinsames Quellcode-Repository zu integrieren. Nutze Tools für automatisierte Tests und Deployments. Bei jeder Änderung an deinem Modell laufen automatisch Tests. Nur erfolgreiche Tests führen zur Überführung in die Produktion. Das steigert die Qualität und Zuverlässigkeit deiner ML-Lösungen enorm.

Beherrsche dein Datenmanagement

Daten sind das Herzstück jedes ML-Projekts. Implementiere eine Versionskontrolle für deine Daten (ähnlich wie für deinen Code). Tools ermöglichen es dir, Datensätze zu versionieren und reproduzierbare Experimente durchzuführen.

Achte auf die Datenqualität. Implementiere automatisierte Checks, um Datenfehler oder -drift frühzeitig zu erkennen. So verhinderst du, dass fehlerhafte Daten deine Modelle negativ beeinflussen.

Überwache deine Modelle in Produktion

Kontinuierliches Monitoring ist entscheidend, um die Leistung deiner Modelle in der realen Welt zu verfolgen. Nutze Tools für das Sammeln von Metriken und die Visualisierung.

Überwache nicht nur die Modellperformance, sondern auch Systemmetriken wie Latenz oder Ressourcenverbrauch. Implementiere Alarmsysteme, die dich bei Überschreitung bestimmter Schwellenwerte benachrichtigen. So handelst du proaktiv, bevor Probleme eskalieren.

Fördere Zusammenarbeit und Wissensaustausch

MLOps ist auch eine Frage der Unternehmenskultur. Fördere die Zusammenarbeit zwischen Data Scientists, Entwicklern und Fachabteilungen. Implementiere Plattformen zur Versionierung von Modellen und Experimenten. Das macht den ML-Prozess transparent und fördert den Wissensaustausch im Team.

Mit diesen Praktiken optimierst du nicht nur deine ML-Workflows, sondern steigerst auch die Qualität und Zuverlässigkeit deiner KI-Lösungen. Im nächsten Abschnitt werfen wir einen Blick darauf, wie du diese MLOps-Strategien nutzt, um deine KI-Projekte erfolgreich zu skalieren.

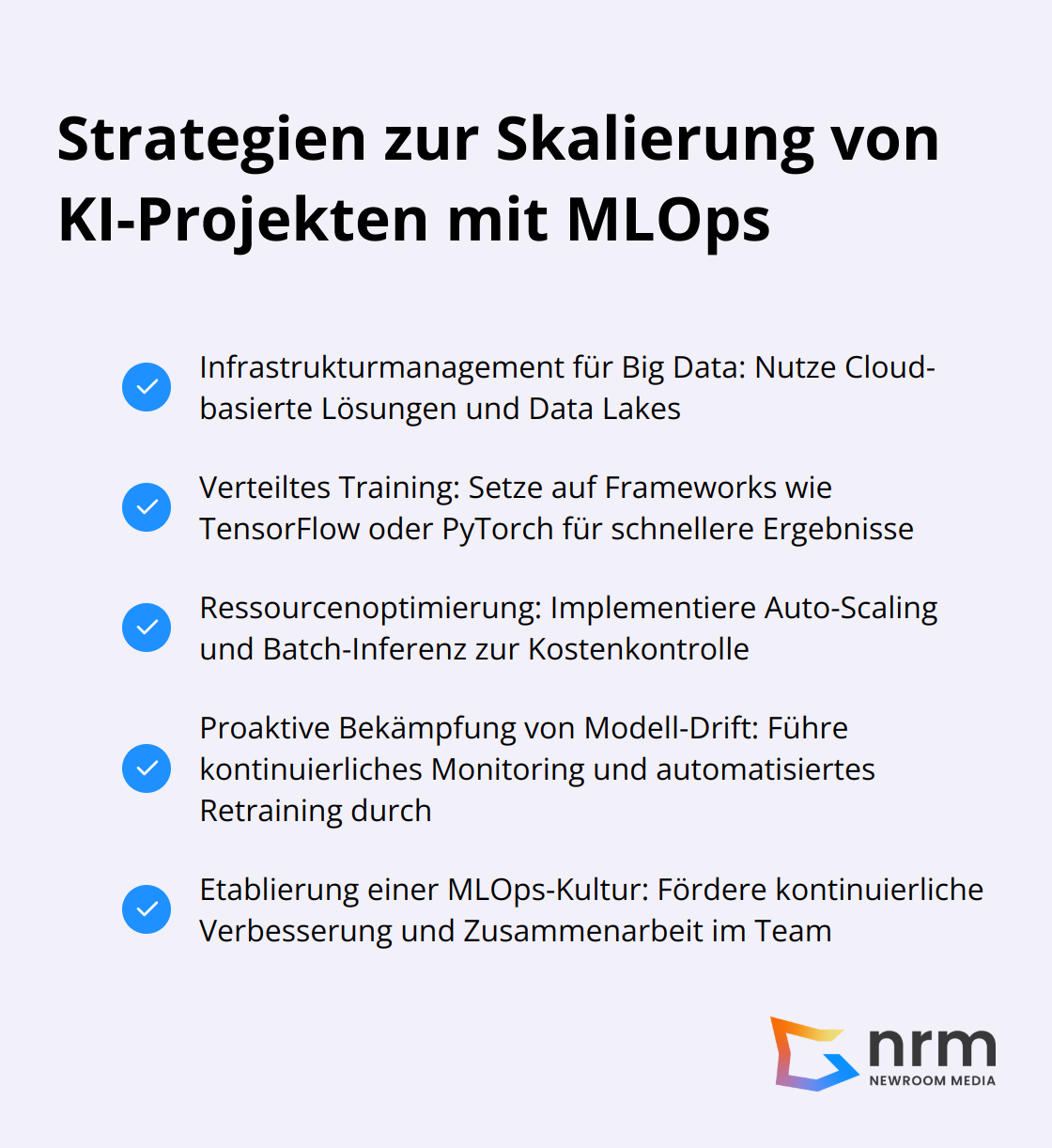

Wie skalierst du KI-Projekte mit MLOps?

MLOps ist der Schlüssel zur erfolgreichen Skalierung deiner KI-Projekte. Mit den richtigen Strategien bringst du deine Modelle effizient auf Unternehmensgröße und optimierst dabei Kosten und Ressourcen.

Infrastrukturmanagement für Big Data

Bei der Skalierung von KI-Projekten stellst du dich der Herausforderung, große Datenmengen zu managen. Cloud-basierte Lösungen (wie S3 oder Blob Storage) bieten dir kostengünstige und skalierbare Datenspeicherung. Du verwaltest damit Petabytes an Daten, ohne dich um die zugrunde liegende Infrastruktur zu kümmern.

Data Lakes ermöglichen dir, große Mengen von Daten zu speichern. Du integrierst verschiedene Datenquellen und trainierst Machine Learning-Modelle mit umfangreichen, vielfältigen Datensätzen.

Verteiltes Training für schnellere Ergebnisse

Um deine Modelle schneller zu trainieren, setzt du auf verteiltes Training. Frameworks wie TensorFlow oder PyTorch unterstützen dies nativ. Du verteilst das Training auf mehrere GPUs oder sogar mehrere Maschinen.

Durch Techniken wie Data Parallelism oder Model Parallelism maximierst du die Effizienz deines Trainings. Die Trainingszeit für große Sprachmodelle reduzierst du von Wochen auf Tage.

Optimiere Ressourcen und kontrolliere Kosten

Ressourcenoptimierung ist entscheidend für die Skalierung deiner KI-Projekte. Auto-Scaling-Funktionen in Cloud-Umgebungen passen Ressourcen dynamisch an den Bedarf an. Du reduzierst deine Kosten erheblich.

Für Anwendungsfälle ohne Echtzeit-Vorhersagen implementierst du Batch-Inferenz. Du nutzt Ressourcen effizienter und senkst Kosten. Große Mengen an Inferenz-Jobs verarbeitest du mit spezialisierten Tools.

Bekämpfe Modell-Drift proaktiv

Modell-Drift stellst du dich bei der Skalierung von KI-Projekten. Du implementierst kontinuierliches Monitoring, um Veränderungen in der Modellleistung frühzeitig zu erkennen. Wichtige Metriken überwachst du in Echtzeit.

Automatisierte Retraining-Pipelines erstellen und deployen bei Bedarf neue Modellversionen. Du verbesserst deine Modellgenauigkeit signifikant durch proaktives Vorgehen gegen Modell-Drift.

Etabliere eine MLOps-Kultur

Die Implementierung von MLOps-Strategien ist mehr als nur Technologie. Du schaffst eine Kultur der kontinuierlichen Verbesserung und des Lernens. Fördere die Zusammenarbeit zwischen Data Scientists, Entwicklern und Fachabteilungen.

Du implementierst Best Practices wie Code Reviews, Pair Programming und regelmäßige Retrospektiven. So steigerst du nicht nur die Qualität deiner ML-Lösungen, sondern auch die Fähigkeiten deines Teams.

Fazit

MLOps revolutioniert die Art und Weise, wie Unternehmen KI-Projekte entwickeln und skalieren. Du optimierst nicht nur deine ML-Workflows, sondern steigerst auch die Qualität und Zuverlässigkeit deiner KI-Lösungen erheblich. Durch Automatisierung, kontinuierliches Monitoring und eine kollaborative Unternehmenskultur schaffst du die Grundlage für nachhaltige KI-Initiativen.

Mit MLOps meisterst du Herausforderungen wie Big Data Management, verteiltes Training und Ressourcenoptimierung effizient. Du reagierst schnell auf Veränderungen, verbesserst deine Modelle kontinuierlich und sicherst ihre langfristige Leistungsfähigkeit. Die Implementierung von MLOps bringt dir enorme Vorteile: gesteigerte Effizienz, reduzierte Kosten und minimierte Risiken in der KI-Entwicklung.

Wenn du Unterstützung bei der Implementierung von MLOps in deinem Unternehmen suchst, kann dir Newroom Media helfen. Mit maßgeschneiderten Digitalisierungslösungen unterstützt dich Newroom Media dabei, deine KI-Projekte auf das nächste Level zu heben. Investiere in MLOps und lege das Fundament für langfristigen Erfolg in der KI-Entwicklung.